InFoBench:评估大型语言模型中的指令跟随能力

抽象的

本文介绍了分解需求遵循率 (DRFR),这是一种用于评估大型语言模型 (LLM) 遵循指令的能力的新指标。 为了解决当前方法论中的差距,DRFR 将复杂的指令分解为更简单的标准,有助于详细分析法学硕士对任务各个方面的遵守情况。 除了这个指标之外,我们还提出了 InFoBench,这是一个基准测试,包含 500 条不同的指令和跨多个约束类别的 2,250 个分解问题。 我们的实验将 DRFR 与传统评分方法进行比较,并探索注释源,包括人类专家、众包工作人员和 GPT-4。 研究结果证明了 DRFR 具有更高的可靠性以及使用 GPT-4 作为经济高效的注释器的有效性。 使用该框架对几个高级法学硕士进行的评估揭示了他们的优势和需要改进的领域,特别是在复杂的指令遵循方面。 这项研究提供了一个新颖的指标和基准,为未来法学硕士的发展和评估提供了见解。 111我们在https://github.com/qinyiwei/InfoBench发布我们的代码和数据集。

1简介

自然语言处理 (NLP) 领域的快速发展见证了大型语言模型 (LLM) 的出现和崛起(Ouyang 等人,2022;Brown 等人,2020;OpenAI,2023b;Touvron 等人,2023;Bai 等人,2022;Chowdhery 等人,2022;Zhang 等人,2022),在模拟类人文本生成方面表现出了非凡的能力。 他们遵循指令的能力对于实际应用至关重要,因为它可以根据特定用户需求定制输出。 尽管如此,这些模型的评估经常强调一般自然语言任务(Wang 等人,2018,2019;Hendrycks 等人,2020;Srivastava 等人,2022;Liang 等人,2022),或特定下游任务(Qin 等人,2023;Bang 等人,2023),而指令遵循的关键要素——模型准确理解和执行用户指令的能力——尚未得到彻底探索。 研究中的这种明显差距以及缺乏专门针对这一关键方面的系统评估方法是我们目前研究的动力。 我们的目标是建立一个可靠的协议和基准来评估法学硕士的遵循指令的能力。

当前的研究倾向于使用 A/B 测试等评估方法(Askell 等人,2021;Taori 等人,2023;Chiang 等人, 2023;Li 等人,2023b;Wang 等人,2023c),总分 (Wang 等人, 2022),以及 Elo 评级 (Zheng 等人,2023;Bai 等人,20220>;Glaese 等人,20221>)——A/B 测试的衍生产品。 虽然这些策略已被证明在一定程度上有效,但它们存在相当大的缺点,包括可扩展性问题和缺乏可解释性。 例如,A/B 测试需要对 N 个系统进行 次比较。 此外,整个评分系统不透明且难以解释,无法阐明为特定指令分配特定分数背后的推理。

在本研究中,我们提出了一种评估法学硕士指令遵循能力的新指标,即分解需求遵循率(DRFR)。 与传统指标不同,DRFR 将每条指令分解为更简单、独特的标准,从而可以更详细、更精确地评估法学硕士遵循给定任务特定方面的能力。 这种分解可以进行精细评估,根据指令中的每个单独要求来衡量法学硕士的合规性,从而更清晰地了解模型在复杂的指令跟踪场景中的性能。 此外,我们还构建了由 500 条不同指令组成的基准,并提供了 2,250 个分解问题来评估指令遵循情况。 为了便于更细粒度的分析,我们将每条指令中存在的约束分为五类:内容、语言、风格、格式和数量。 我们还为每个分解的问题手动策划约束标签,以识别和分析每个模型中潜在的缺陷领域。

我们进行了两个关键实验:首先,我们将 DRFR 指标与传统的直接评分 (DS) 进行比较,以评估各种大型语言模型 (LLM) 的响应。 结果显示,DRFR 注释者之间达成了更高的共识,特别是在 Hard Set 中,这表明其比直接评分 (DS) 具有更高的可靠性。 其次,我们通过比较人类专家、Amazon Mechanical Turk (AMT) 的众包工作人员和 GPT-4 来探索更具成本效益的注释源。 研究结果显示,虽然人类专家的准确率最高,但成本高昂且耗时。 AMT 工作人员提出了一种平衡,但准确性较低。 值得注意的是,GPT-4 成为一种高度准确、经济高效且省时的替代方案,特别是在采用结构化、多轮提示方法时,使其成为大规模注释的可行选择。

因此,我们使用 GPT-4 作为注释器来评估整个 InFoBench。 对这些高级法学硕士的综合评估表明,虽然取得了显着的进步,但他们在完美遵循指示的能力方面仍然存在显着差距,特别是在以“Hard Set”为代表的更复杂的场景中。 闭源模型目前处于领先地位,可能是由于更好的数据或更复杂的算法。 然而,不同约束类型和领域的表现表明,指令遵循方面的挑战更加微妙,可能需要在数字和语言理解等领域进行重点改进。 随着法学硕士的不断发展,解决这些特定领域可能会产生更强大、更通用的大语言模型,能够处理更广泛的现实世界任务和指令。

我们的研究提出了评估大型语言模型 (LLM) 遵循指令的能力领域的四个关键贡献。 首先,我们引入了一种新颖且可扩展的指标,即分解需求遵循比率(DRFR),它为评估法学硕士提供了可靠、详细且可解释的框架。 该指标将复杂的指令分解为更简单、具体的标准,从而可以对模型的性能进行精细分析。 其次,我们开发了综合基准数据集InFoBench。 它包括 500 条不同的指令,搭配 2,250 个分解问题,旨在系统地测试和分析法学硕士的指令跟踪能力。 第三,通过大量的实验,我们确定了DRFR和InFoBench的功效。 我们的研究结果强调了使用 GPT-4 作为准确性和成本效益评估器的潜力,特别是在采用结构化、多轮提示时。 最后,我们利用自动评估工具包对六名高级法学硕士进行了彻底分析。 这项评估不仅强调了这些模型的当前功能,而且还揭示了需要改进的特定领域,以实现更细致和更有效的指令遵循,特别是在复杂的场景中。 这些贡献为法学硕士发展和评估的未来进步铺平了道路。

2 InFoBench

评估指标和基准数据集在客观评估大型语言模型 (LLM) 遵循指令的能力方面发挥着不可或缺的作用。 这些工具对于实现一致的比较、查明需要改进的领域以及确保这些模型在实际应用中的实用性、公平性和有效性至关重要。 在2.1节中,我们介绍了一种新颖的评估指标,称为D分解的R要求F以下比率 (DRFR)。 该指标专门用于衡量法学硕士以详细和结构化的方式遵守复杂指令的熟练程度。 此外,第2.2节讨论了相应基准数据集InFoBench的开发,该数据集经过精心策划,旨在严格测试和评估法学硕士的指令跟踪能力。 该数据集呈现了各种场景和挑战,为对这些模型的性能进行基准测试和改进提供了全面的工具。

2.1DRFR

| Instruction | Decomposed YES/NO Questions |

|---|---|

|

Make a questionnaire to help hotel guests write hotel reviews. |

1. Is the generated text a questionnaire?

|

|

Please generate 10 one-sentence hotel reviews from ten different customers, ensuring that 5 of the reviews are positive and 5 are negative. Begin each review with "CUSTOMER" and the customer’s number. After completing the 10 reviews, provide a two-sentence summarization that captures the overall sentiment and key points from the reviews. |

1. Does the generated text include hotel reviews?

|

为了评估高级语言模型准确遵循指令的能力,一种常见的方法是咨询评估者,了解模型的响应是否以及如何与给定指令保持一致。 然而,这种方法在实践中经常遇到困难,因为评估者之间达成共识可能具有挑战性,特别是在模型部分满足指令某些方面的情况下。 评估高级语言模型与复杂指令的合规性的一个可行策略是将每条指令分割成不同的、更简单的标准,使评估者更容易判断。 考虑由 条指令组成的基准数据集。 每条指令都可以分解为 独特的要求。 变量 表示第 在这种情况下,我们可以将分解需求遵循率 (DRFR) 定义如下:

| (1) |

该指标量化了模型对整个数据集分解标准的遵守情况,提供对其指令跟踪功能的细致入微的理解。 表1提供了两个说明性的指令示例,每个示例都附有各自的分解标准。 这些标准被构建为二元问题,需要回答是或否。 YES 答案表示大型语言模型 (LLM) 的输出成功满足问题中概述的特定标准,对应于 。 需要强调的是,即使是与要求的微小偏差也会导致负面(否)响应,因为严格遵守是强制性的。 例如,在表1中第二个示例的第三个问题中,即使出现一条长度超过一句话的酒店评论,也需要回答NO。 另一方面,NO表示法学硕士的输出不满足要求或未能提供与指定标准相关的相关信息。

2.2 InFoBench数据集

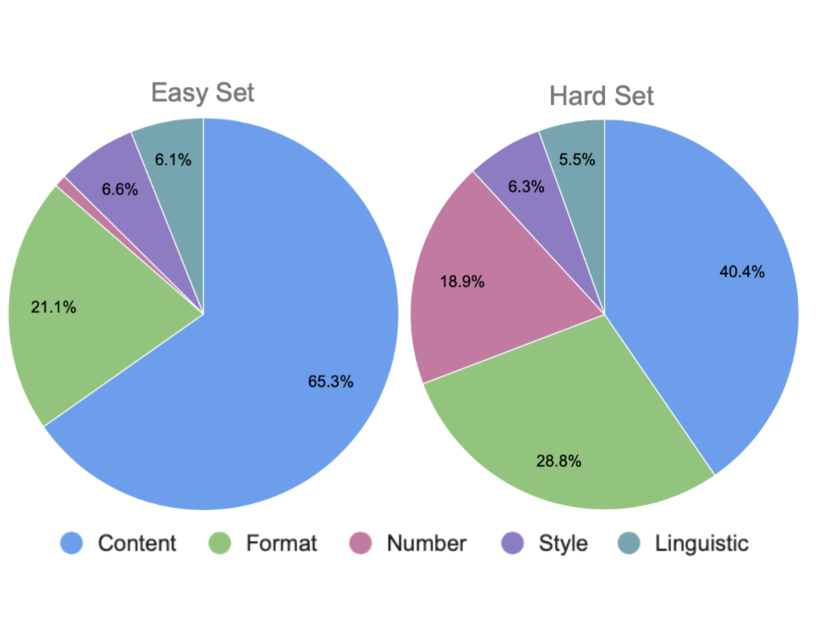

为了有效地对指令跟踪能力进行基准测试,开发包含广泛不同指令的数据集至关重要。 这种方法可确保全面覆盖,并能够更准确地评估遵循指示的熟练程度。 InFoBench 通过两个不同的组满足了这一需求:Easy Set 和 Hard Set。 Easy Set 基于(Wang 等人,2022) 的研究,专为广泛的应用而设计。 相比之下,硬集是我们最初的贡献,由受各个主题领域启发的手动整理的数据集组成。 表1展示了医院审查背景下两组的示例。 而Easy Set已广泛用于评估((Wang et al, 2022; Li et al, 2023b; Taori et al, 2023b)等人,2023;Peng 等人,2023;Anand 等人,2023;Wang 等人,2023c) ),我们的工作导致了Hard Set的创建,解决了Easy Set的局限性:1)0>其说明相对简单,限制了区分现代法学硕士表现的能力; 2)1> 它的约束类型种类有限,通常每条指令只有大约三个,缺乏整体多样性; 3)2>简易设置3>通常包含模糊和主观的要求,例如在其说明中很难普遍定义“有帮助”等术语。 例如,在表1中,Easy Set的指令要求调查问卷“有帮助”,但事实证明,就“有帮助”的定义达成共识是很困难的。难的。

为了保证说明的质量和要求的清晰度,每条说明及其分解的要求均由主题专家精心制作,并随后由另一位专家进行验证。 收集实例的过程一直持续到两位专家都同意指令的自然性以及分解的需求的原子性和清晰性为止。

2.2.1 指令开发

我们的目标是制定覆盖范围广泛的说明,有效区分优劣型号。 我们开发了硬集,涵盖 72 个领域,涵盖自然科学、社会科学、工程、经济、艺术、各种职业任务和日常生活的各个方面,如图 1。

我们还在这些说明中纳入了具体的回应限制:1) 内容限制:这些定义了法学硕士回应中要解决的特定主题或细节,例如讨论“气候变化影响” >”或提及“《哈利·波特》中的主要角色”; 2) 语言准则:这些准则规定了特定语言结构和术语的使用,包括语法风格、语法和特定方言,例如“维多利亚英语”或“技术术语”; 3) 风格规则:这些规则指导文本的整体语气和受众,从正式到有说服力或复杂,如以“尊重的语气”或“ 年轻观众”; 4) 格式规范:这些指导法学硕士对其响应的结构表示,例如“制作十四行诗0>”或“按项目符号列出想法1>”; 5) 数量限制2>:这些涉及与数字相关的说明,例如撰写“一篇 500 字的文章3>”或提出“可再生能源的三个论点4> ”。

2.2.2 指令分解

在指令开发过程中,我们为每条指令精心设计了详细的要求和相关的二元问题,每个问题都反映了一个特定的约束条件,可以用“是”或“否”来回答。 利用我们建立的约束类型本体,我们使用适当的约束标签手动对每个问题进行分类,并注意到单个需求可以体现多种约束类型。 例如,问题“生成的文本是否对文森特·梵高的《星夜》提出了批评?由于其重点是“星夜”,因此受到内容限制,同时也符合格式限制,因为批评代表了独特的写作风格。 因此,我们为每个问题分配了一种或多种约束类型,数据集中的每个约束最多标记为三种类型。

2.2.3 基准统计

| #Inst. | Len. | #Req. | #R/I | #Dom. | |

|---|---|---|---|---|---|

| Easy | 252 | 17.77 | 690 | 2.74 | 71 |

| Hard | 248 | 59.26 | 1560 | 6.29 | 72 |

| Overall | 500 | 38.35 | 2250 | 4.50 | 143 |

表 2 提供了对 InFoBench 的统计见解,突出了两组之间的显着差异。 硬集的特点是指令更精细、要求更多,与简单集相比,复杂程度更高。 此外,该表强调了数据集的多样性,这在它所涵盖的广泛领域中显而易见。

3实验

3.1 DRFR 与 直接计分

在我们的研究中,我们旨在通过将 DRFR 指标与传统的直接评分方法进行对比来评估其可靠性。 在直接评分 (DS) 中,人类评估者为模型生成的每个响应分配从 1(表示最低质量)到 5(表示最高质量)的分数。 每个评级的标准详细说明如下: Rating-1(非常差):模型的响应与提出的查询完全无关。 它表明不理解所请求的任务。 Rating-2(差):虽然与原始指令有最小程度的相关性,但响应主要是不正确的、令人困惑的或两者兼而有之。 Rating-3(好的):回复显示与所提出的问题存在一定关系,但缺乏关键细节或包含不准确之处。 Rating-4(良好):当响应基本准确且全面时,给出此评级。 但是,它可能包含轻微错误或省略次要细节。 Rating-5(优秀):获得此评级的响应完全准确、详细,并且完全符合查询的要求。

在我们的评估中,我们纳入了五种广泛认可的大型语言模型 (LLM),每种模型都以其独特的特征和训练方法而著称:GPT-3.5-turbo (Ouyang 等人,2022 ):OpenAI 对 GPT-3 (Brown 等人,2020) 进行了 1750 亿个参数扩展,通过以下方式增强了与用户意图的一致性基于人类反馈的强化学习。 GPT-4 (OpenAI,2023b):该模型是 GPT-3.5-turbo 的高级、大规模后继者。 Claude-v1 (Bai 等人,2022):Anthropic 的 520 亿参数人工智能助手 Claude-v1 经过训练,变得乐于助人、诚实,并且利用人类反馈的强化学习是无害的。 Alpaca-7B (Taori 等人,2023):Alpaca-7B 是一个开源模型,源自 70 亿参数的 LLaMA 基础(Touvron 等人,2023),并使用数据集进行微调(Wang 等人,2022)专注于遵循指令的能力。 Vicuna-13B (Chiang et al, 2023):Vicuna-13B 是一个由 LLaMA 微调的 130 亿个参数的开源模型,整合来自 ShareGPT 平台的各种现实世界交互222https://sharegpt.com。

此外,我们还汇总了 InFoBench 上模型生成的响应,并聘请三位 NLP 专家利用两种不同的方法对其进行独立评估。 最初,他们应用直接评分 (DS),然后使用 DRFR 指标进行评估。 此顺序旨在减少任何潜在的偏差:通过在 DS 评估之后进行 DRFR 评估,我们的目标是防止评估者在 DRFR 评估期间形成的印象影响他们的评价。 DS 评估。 这确保了评估过程更加客观和公正。

此外,为了促进两个评估指标之间的公平比较,我们将两者标准化为指令级分数。333DS uses the score provided by the evaluator, DRFR counts all the stratified requirements and normalized by the number of requirements in the instruction这可以对来自两个不同模型(称为模型 A 和模型 B)的响应对进行直接并排比较。 对于每个指导提示,配对响应分为三个不同的类别:1)模型 A 优于模型 B,2)模型 A 和模型 B 同等有效,3)模型 B 优于模型 A。 最后,采用 Fleiss’ Kappa 协议(Fleiss,1971)来衡量三个评估者之间关于成对分类的协议。 这种配对 Kappa 协议方法确保了我们对评估指标的比较分析的清晰度和准确性。

| Pairwise Kappa Agreement | |||

|---|---|---|---|

| Metric | Easy(25) | Hard(25) | Overall(50) |

| DS | 0.241 | 0.302 | 0.284 |

| DRFR | 0.537 | 0.493 | 0.532 |

表 3 显示了从 InFoBench 中选择的 50 个实例的两个指标的配对 Kappa 协议,其中包含来自 Easy 和 Hard 子集的 25 个实例的相等组合。 观察到的 DRFR 和直接评分 (DS) 之间的差距超过 0.19,这表明 DRFR 产生了明显更高的注释者共识,从而意味着其可靠性增强用于人工注释。

3.2 注释源实验

为了寻找更具成本效益的注释来源,我们利用各种来源的注释进行了比较研究,包括人类专家、Amazon Mechanical Turk (AMT) 的众包工作人员以及 GPT-4 等高级大型语言模型。 本次对比详情如下:

人类专家注释:使用了之前在3.1节中讨论过的三位专家的注释。 鉴于指令集涵盖的主题范围广泛,单个专家不可能全面精通所有主题。 因此,我们实施了多数投票制度,并辅以在线研究工具的使用,以提高这些专家注释的准确性。

众包注释:我们聘请了来自 Amazon Mechanical Turk (AMT) 平台的注释者444https://www.mturk.com/,选择 HIT 批准率高于 90% 且至少有 500 个已批准的 HIT 的项目。 每项任务,包括指令及其相应的响应,都被分配给三个不同的注释者。 我们对每个离散查询采用多数投票方法,对指令采用聚合评分方法。 该评估方法的具体细节在附录A.3中详细阐述。

基于 GPT-4 的注释:我们采用了 GPT-4 模型555版本:gpt-4-0314。 用于自动评估。 该方法涉及发出一系列多轮提示,依次向 GPT-4 呈现分解的问题,同时考虑先前答案提供的上下文。 该提示结构的具体细节详见附录A.2。

| Robustness | ||||||||

|---|---|---|---|---|---|---|---|---|

| Source | Cost($) | Time(min) | ACC(%) | PLD0(%) | PLD1(%) | PLD2(%) | WPLD | |

| Easy Set(25) | Expert | 472.00 | 480 | 100.0 | 100.0 | 0.0 | 0.0 | 0 |

| AMT | 93.75 | 960 | 90.0 | 51.8 | 37.6 | 10.6 | 0.588 | |

| GPT-4 | 5.40 | 20 | 93.0 | 65.6 | 34.4 | 0.0 | 0.344 | |

| Hard Set(25) | Expert | 944.00 | 960 | 100.0 | 100.0 | 0.0 | 0.0 | 0 |

| AMT | 93.75 | 1,200 | 81.0 | 51.4 | 31.6 | 17.0 | 0.656 | |

| GPT-4 | 14.20 | 40 | 87.0 | 52.4 | 41.6 | 6.0 | 0.536 | |

| Overall(50) | Expert | 1,416.00 | 1,440 | 100.0 | 100.0 | 0.0 | 0.0 | 0 |

| AMT | 187.50 | 2,160 | 84.0 | 51.6 | 34.7 | 13.7 | 0.621 | |

| GPT-4 | 19.40 | 60 | 89.0 | 59.0 | 38.0 | 3.0 | 0.440 | |

在表4中,我们对各种注释源进行了比较分析,强调了它们的成本、时间效率和注释鲁棒性。 我们通过汇总三位 NLP 专家的总工作时间来计算专家注释的成本。 根据 ZipRecruiter 的薪资数据,每小时费率为 59 美元。666https://www.ziprecruiter.com/Salaries/NLP-Salary AMT工作人员的支出是根据平台支付的总金额计算的。 每个注释任务包括一条指令和五个模型响应,被分配给三个注释者。 每个注释者的报酬为 1 美元,另加 25% 的平台费用。 AMT标注的总时间是从AMT平台统计中获得的。 使用 GPT-4-0314 模型的成本由其基于代币的定价结构决定777https://platform.openai.com/docs/deprecations,每 1,000 个提示令牌 0.03 美元,每 1,000 个完成令牌 0.06 美元。 GPT-4 的操作限制包括每分钟 200 个请求的限制和每分钟最多 40,000 个令牌的限制。888https://platform.openai.com/docs/guides/rate-limits?context=tier-free使用GPT的总成本和时间支出-4 是根据任务执行期间使用的提示和完成令牌的累积计数计算的。 为了评估注释源的鲁棒性,我们继承了3.1节中提到的成对比较。 这三个类别分别用 1) 模型 A 优于模型 B,2) 模型 A和模型 B 同等有效,并且 3) 模型 B 优于模型 A。 引入成对标签距离(PLD)来衡量注释与真实标签之间的一致性。 PLD 值为 0 表示注释准确反映了给定响应对的模型的相对性能顺序。 PLD 为 1 表明在模型表现相同的场景(“平局”场景)中存在潜在的错误分类,可能会导致一个模型优于另一个模型,反之亦然。 PLD 为 2 表示注释错误地表示了模型性能的顺序。 加权成对标签距离(WPLD)定义如下:

| (2) |

我们的分析得出两个重要发现:1) 与 AMT (Amazon Mechanical Turk) 众包工作者生成的注释相比,GPT-4 生成的注释表现出卓越的成本效益和时间效率。 此外,GPT-4 在注释任务中展示了增强的整体性能。 2) 当采用分解问题时,GPT-4的表现尤其值得注意。 它的准确率达到 89%,加权成对标签距离为 0.44,符合黄金标准。 这些结果表明,与分解问题结合使用的 GPT-4 成为传统基于专家的注释的可行且有效的替代方案,特别是在考虑成本和时间效率之间的平衡时。 鉴于这些发现,我们在 InFoBench 上评估模型时强调使用 GPT-4 模型进行注释任务,考虑到其在成本、时间效率和准确性之间的有利平衡。

4自动评估

根据我们之前的实验结果,很明显 GPT-4 代表了专家注释的更好替代方案。

这种方法不仅提供了高精度,而且还确保了注释过程的时间效率和成本效益。 基于这一见解,我们将 gpt-4-0314 与多轮提示相集成,以扩大整个 InFoBench 与六个最前沿的 LLM 的评估。

其中包括:gpt-3.5-turbo-1106 Brown et al (2020) 和 gpt4-1106-preview OpenAI (2023a) 由 OpenAI、Claude-2.1 发布 MistralAI (2023) 由 Anthropic、Gemini-Pro 团队 (2023) 由 Google、Llama-2-70b-chat Hugo 等人 (2023) 由 Meta 和 Vicuna-13b-v1.5 Zheng 等人 ( 20231>)0> 由 LMSYS 提供。

为了避免解码过程中的随机性,我们使用贪婪解码9990>

| Model Name | Easy Set | Hard Set | Overall |

|---|---|---|---|

| gpt-4-1106-preview | 90.1 | 89.1 | 89.4 |

| gpt-3.5-turbo-1106 | 90.4 | 85.1 | 86.7 |

| claude-2.1 | 82.9 | 87.9 | 86.4 |

| gemini-pro | 87.3 | 84.9 | 85.6 |

| Llama-2-70b-chat | 89.6 | 82.1 | 84.4 |

| Vicuna-13b-v1.5 | 86.1 | 75.0 | 78.4 |

总体:表5显示了由gpt-4-0314支持的InFoBench上选定模型的自动DRFR分数。 通过分析表中的数据,可以得出三个关键观察结果:(1)GPT-4 表现出优于其他法学硕士的表现,在所有法学硕士中得分最高。 然而,即使有了这种最先进的模型,仍有超过 10% 的要求未得到满足,这表明在指令遵循方面迫切需要进一步增强。 (2) 与困难组相比,除Claude-2.1之外的所有模型在简单组上表现出更好的性能,这意味着困难组姿势更艰巨的挑战。 (3) 闭源模型(例如gpt-4-1106-preview、gpt3.5-turbo-1106、claude-2.1、gemini-pro)在Hard Set上的性能优于开放模型- 来源模型(例如 Llama-2-70b-chat、Vicuna-13b-v1.5),这可能表明它们在更高级的指令上具有更好的数据指令覆盖率,或者它们具有更好的模型泛化能力。

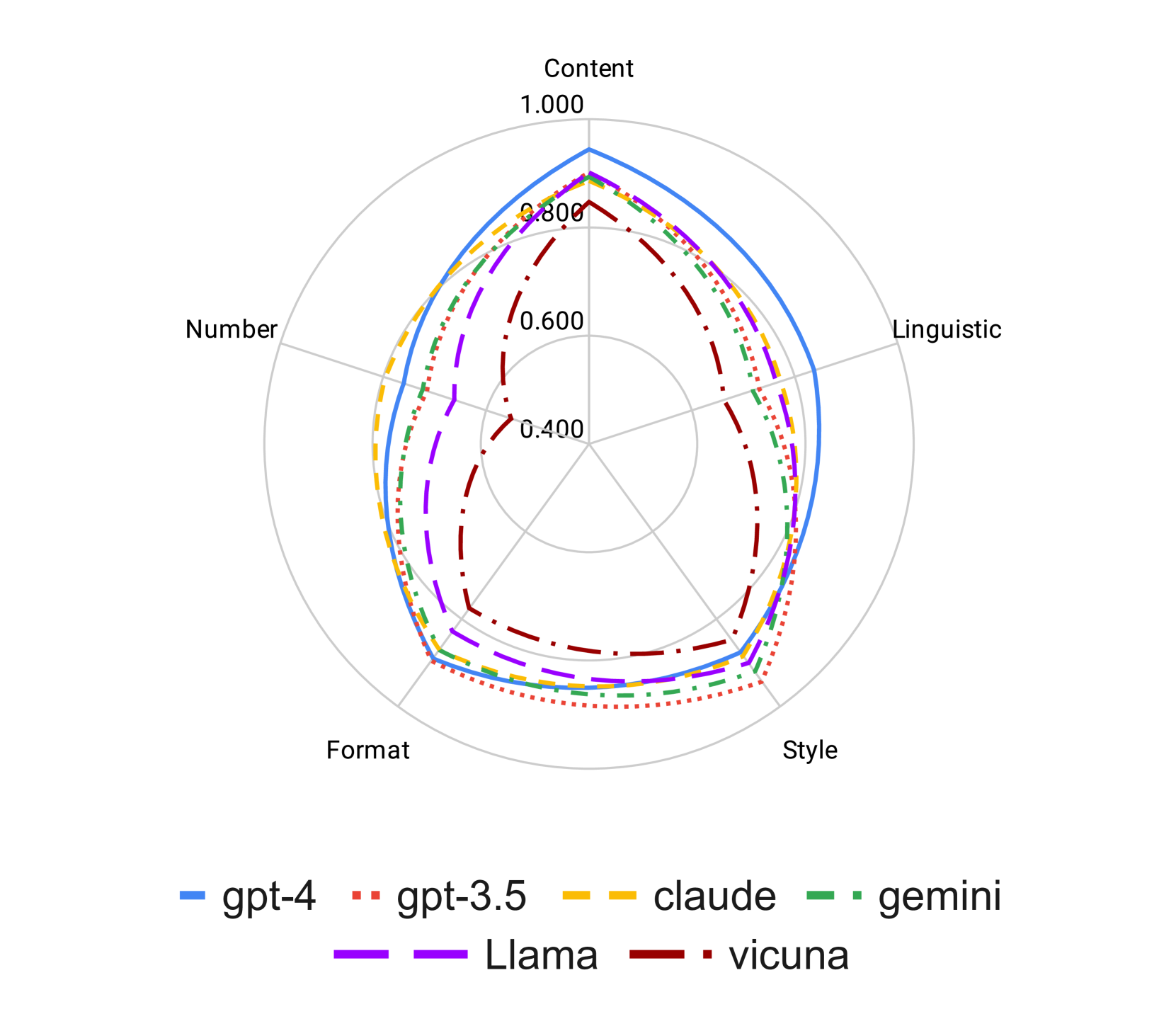

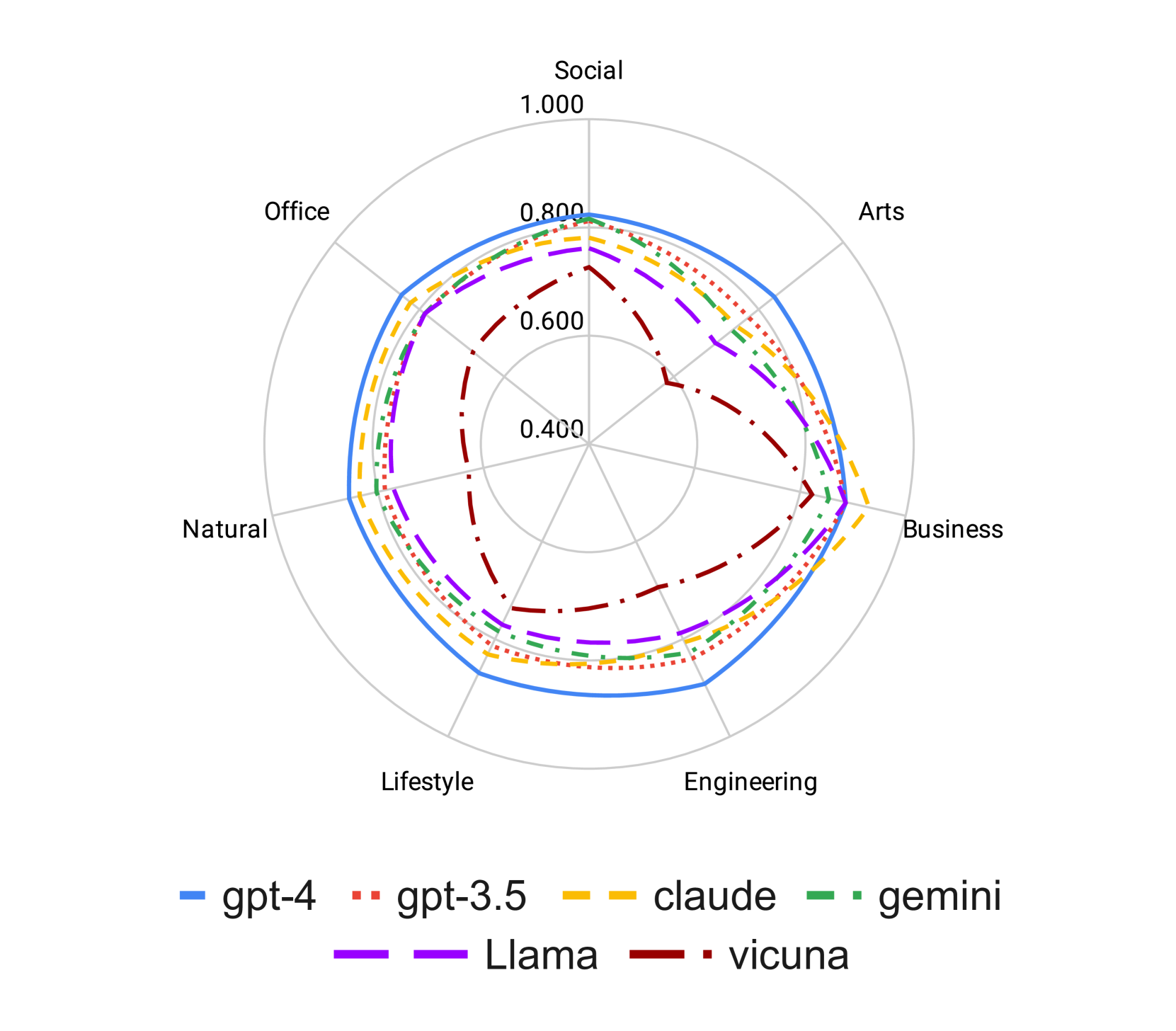

约束类型:为了评估约束类型对遵守指令的影响,我们单独计算每种约束类型的评估分数,如图3所示。 雷达图揭示了不同约束类型的性能的明显模式:内容和风格方面的性能最高,格式方面的性能中等,数量和语言约束方面的性能最低。 在所有六种语言模型中都观察到了这一总体趋势。

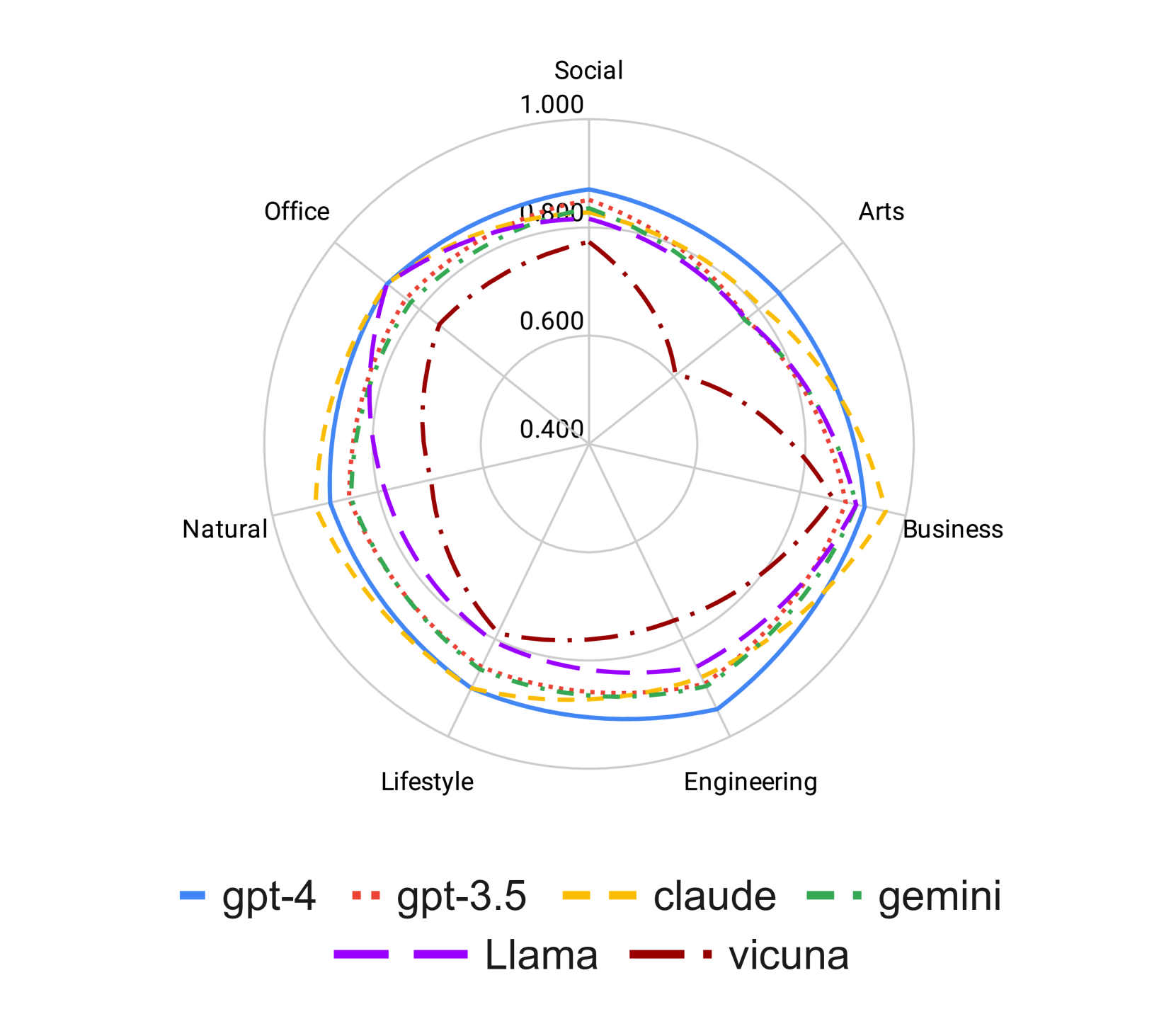

域:为了研究指令域对遵循指令行为的影响,我们将分析限制在硬集中的七个主要主题类别,并独立计算每个指令类别的评估分数,如图4所示。 与上一节中可辨别的模式相反,雷达图上评估分数的最终形状近似于圆形(骆驼除外)。 这表明指令域并不是影响指令遵循的主要因素,或者大多数模型对此类域具有良好的数据覆盖。

5相关工作

法学硕士为增强可用性而进行的调整引起了人们的广泛关注。 这种适应的两种流行方法是指令调整和对齐调整(Zhao et al,2023)。 指令调优(Wang 等人,2022;Lou 等人,2023) 旨在通过对带注释的 LLM 进行微调来解锁 LLM 的功能“指导性”数据。 这涉及具有自然语言指令的数据集及其相应的期望结果。 多个法学硕士改编项目已采用此方法进行有效细化(Taori 等人,2023;Wei 等人,2021;Chung 等人,2022 t3>;Iyer 等人,2022;Ouyang 等人,2022)。 对齐调整(Ziegler等人,2019;Christiano等人,2017;Ouyang等人,2022;Bai等人,2022) 与指令调整不同,它强调人类反馈,以确保法学硕士符合人类价值观和偏好。 这种方法解决了 LLM 表现出无意行为的倾向,例如捏造信息或产生有偏见的表达(Ouyang 等人,2022;Kenton 等人,2021),引导它们更符合人类的期望。

这一研究方向的自然延伸是评估法学硕士准确遵循自然语言指令并符合人类偏好的能力。 在评估方面,使用法学硕士进行自然语言生成(NLG)评估已在许多任务中显示出前景(Zheng等人,2023;Liu等人,2023 ;Wang 等人,2023a;Fu 等人,2023;Kocmi 和 Federmann,2023;Xu 等人,2023 t6>;Chiang 等人,2023;Eldan 和 Li,2023)。 鉴于这种背景,在我们提出的工作中,我们聘请法学硕士作为评估员来评估他们遵循指令的能力。

有几部著作同时从不同角度评估了法学硕士:Wang 等人 (2023b) 探索了法学硕士解决复杂科学问题的推理能力; Wang 等人 (2023c) 提出了一位经过培训的法官 LLM,用于区分不同 LLM 的表现; Li等人(2023a)在分类任务上引入了一种名为verbalizer操作的指令跟踪评估协议; Li 等人 (2023b) 开发了一种基于 LLM 的自动评估方法,用于计算给定模型的输出优于 805 指令上的参考模型的胜率数据集(Dubois等人,2023); Xu等人(20231>)0>提出了一种自动方法来编写用于指令调优的复杂指令; Chia 等人 (20233>)2> 推出了一套评估套件,旨在评估经过教学调整的法学硕士在解决问题、写作熟练程度以及与人类价值观的一致性方面的能力。

6结论

这项研究在通过分解需求遵循比率 (DRFR) 评估大型语言模型 (LLM) 方面取得了重大突破,这是一种新颖的指标,可将复杂的指令分解为更简单的标准,以进行更细致的分析。 这种方法与综合基准数据集 InFoBench 的创建相结合,可以对法学硕士的指令跟踪能力进行详细评估。 我们的研究结果揭示了 DRFR 相对于传统评估方法的优越性,为模型性能提供了更清晰的见解,尤其是在复杂的场景中。 使用 GPT-4 作为注释器成为大规模评估的一种经济高效、准确且高效的替代方案,凸显了其在自动化和增强评估过程方面的潜力。

使用我们的方法对各种法学硕士进行综合评估,发现了他们的优势和需要改进的领域。 虽然显着的进步是显而易见的,特别是在闭源模型方面,但处理复杂指令方面仍然存在挑战,这表明需要在数字推理和语言理解等领域取得进步。 我们的贡献为未来的研究和开发奠定了基础,指导法学硕士的增强,以在实际应用中获得更准确、更可靠的性能。 这项研究不仅强调了法学硕士当前的能力,还为下一代更强大、更通用的人工智能模型铺平了道路。

局限性

这项研究并非没有其局限性,必须承认:

1. 人工注释所需的成本和资源限制了我们只能为指令集的一小部分提供这些注释。 具体来说,只有 10% 的指令集(相当于 50 条指令)是由人类注释的。 因此,我们分解的协议的可靠性、与基线协议的比较以及不同注释之间的比较仅基于该子集。

2. 我们的数据集的大小带来了另一个限制。 它包含 500 条指令和 2,250 个分解问题,代表了一个有限的基准。 我们的指令编写过程的手动性质限制了我们显着扩展该数据集的能力。 未来的工作可以探索开发用于指令编写和问题分解的自动化方法,从而有可能创建更具可扩展性的数据集。

3. 最后,对我们模型的评估主要集中在所提供的说明中包含的明确意图。 本研究没有考虑真实性和无害性等几个关键因素(Askell 等,2021)。 这些要素虽然在我们当前的工作中没有得到解决,但代表了后续研究工作的有希望的途径。

参考

- Anand et al. (2023) Yuvanesh Anand, Zach Nussbaum, Brandon Duderstadt, Benjamin Schmidt, and Andriy Mulyar. 2023. Gpt4all: Training an assistant-style chatbot with large scale data distillation from gpt-3.5-turbo. GitHub.

- Askell et al. (2021) Amanda Askell, Yuntao Bai, Anna Chen, Dawn Drain, Deep Ganguli, Tom Henighan, Andy Jones, Nicholas Joseph, Ben Mann, Nova DasSarma, et al. 2021. A general language assistant as a laboratory for alignment. arXiv preprint arXiv:2112.00861.

- Bai et al. (2022) Yuntao Bai, Andy Jones, Kamal Ndousse, Amanda Askell, Anna Chen, Nova DasSarma, Dawn Drain, Stanislav Fort, Deep Ganguli, Tom Henighan, et al. 2022. Training a helpful and harmless assistant with reinforcement learning from human feedback. arXiv preprint arXiv:2204.05862.

- Bang et al. (2023) Yejin Bang, Samuel Cahyawijaya, Nayeon Lee, Wenliang Dai, Dan Su, Bryan Wilie, Holy Lovenia, Ziwei Ji, Tiezheng Yu, Willy Chung, et al. 2023. A multitask, multilingual, multimodal evaluation of chatgpt on reasoning, hallucination, and interactivity. arXiv preprint arXiv:2302.04023.

- Brown et al. (2020) Tom Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared D Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, et al. 2020. Language models are few-shot learners. Advances in neural information processing systems, 33:1877–1901.

- Chia et al. (2023) Yew Ken Chia, Pengfei Hong, Lidong Bing, and Soujanya Poria. 2023. Instructeval: Towards holistic evaluation of instruction-tuned large language models. arXiv preprint arXiv:2306.04757.

- Chiang et al. (2023) Wei-Lin Chiang, Zhuohan Li, Zi Lin, Ying Sheng, Zhanghao Wu, Hao Zhang, Lianmin Zheng, Siyuan Zhuang, Yonghao Zhuang, Joseph E. Gonzalez, Ion Stoica, and Eric P. Xing. 2023. Vicuna: An open-source chatbot impressing gpt-4 with 90%* chatgpt quality.

- Chowdhery et al. (2022) Aakanksha Chowdhery, Sharan Narang, Jacob Devlin, Maarten Bosma, Gaurav Mishra, Adam Roberts, Paul Barham, Hyung Won Chung, Charles Sutton, Sebastian Gehrmann, et al. 2022. Palm: Scaling language modeling with pathways. arXiv preprint arXiv:2204.02311.

- Christiano et al. (2017) Paul F Christiano, Jan Leike, Tom Brown, Miljan Martic, Shane Legg, and Dario Amodei. 2017. Deep reinforcement learning from human preferences. Advances in neural information processing systems, 30.

- Chung et al. (2022) Hyung Won Chung, Le Hou, Shayne Longpre, Barret Zoph, Yi Tay, William Fedus, Eric Li, Xuezhi Wang, Mostafa Dehghani, Siddhartha Brahma, et al. 2022. Scaling instruction-finetuned language models. arXiv preprint arXiv:2210.11416.

- Dubois et al. (2023) Yann Dubois, Xuechen Li, Rohan Taori, Tianyi Zhang, Ishaan Gulrajani, Jimmy Ba, Carlos Guestrin, Percy Liang, and Tatsunori B. Hashimoto. 2023. Alpacafarm: A simulation framework for methods that learn from human feedback.

- Eldan and Li (2023) Ronen Eldan and Yuanzhi Li. 2023. Tinystories: How small can language models be and still speak coherent english?

- Fleiss (1971) Joseph L Fleiss. 1971. Measuring nominal scale agreement among many raters. Psychological bulletin, 76(5):378.

- Fu et al. (2023) Jinlan Fu, See-Kiong Ng, Zhengbao Jiang, and Pengfei Liu. 2023. Gptscore: Evaluate as you desire.

- Glaese et al. (2022) Amelia Glaese, Nat McAleese, Maja Trębacz, John Aslanides, Vlad Firoiu, Timo Ewalds, Maribeth Rauh, Laura Weidinger, Martin Chadwick, Phoebe Thacker, et al. 2022. Improving alignment of dialogue agents via targeted human judgements. arXiv preprint arXiv:2209.14375.

- Hendrycks et al. (2020) Dan Hendrycks, Collin Burns, Steven Basart, Andy Zou, Mantas Mazeika, Dawn Song, and Jacob Steinhardt. 2020. Measuring massive multitask language understanding. arXiv preprint arXiv:2009.03300.

- Hugo et al. (2023) Touvron Hugo, Martin Louis, Stone Kevin, Albert Peter, Almahairi Amjad, Babaei Yasmine, Bashlykov Nikolay, Batra Soumya, Bhargava Prajjwal, Bhosale Shruti, Bikel Dan, Blecher Lukas, Canton Ferrer Cristian, Chen Moya, Cucurull Guillem, Esiobu David, Fernandes Jude, Fu Jeremy, and Wenyin Fu. 2023. Llama 2: Open foundation and fine-tuned chat models.

- Iyer et al. (2022) Srinivasan Iyer, Xi Victoria Lin, Ramakanth Pasunuru, Todor Mihaylov, Daniel Simig, Ping Yu, Kurt Shuster, Tianlu Wang, Qing Liu, Punit Singh Koura, et al. 2022. Opt-iml: Scaling language model instruction meta learning through the lens of generalization. arXiv preprint arXiv:2212.12017.

- Jiang et al. (2023) Yuxin Jiang, Yufei Wang, Xingshan Zeng, Wanjun Zhong, Liangyou Li, Fei Mi, Lifeng Shang, Xin Jiang, Qun Liu, and Wei Wang. 2023. Followbench: A multi-level fine-grained constraints following benchmark for large language models.

- Kenton et al. (2021) Zachary Kenton, Tom Everitt, Laura Weidinger, Iason Gabriel, Vladimir Mikulik, and Geoffrey Irving. 2021. Alignment of language agents. arXiv preprint arXiv:2103.14659.

- Kocmi and Federmann (2023) Tom Kocmi and Christian Federmann. 2023. Large language models are state-of-the-art evaluators of translation quality.

- Li et al. (2023a) Shiyang Li, Jun Yan, Hai Wang, Zheng Tang, Xiang Ren, Vijay Srinivasan, and Hongxia Jin. 2023a. Instruction-following evaluation through verbalizer manipulation.

- Li et al. (2023b) Xuechen Li, Tianyi Zhang, Yann Dubois, Rohan Taori, Ishaan Gulrajani, Carlos Guestrin, Percy Liang, and Tatsunori B. Hashimoto. 2023b. Alpacaeval: An automatic evaluator of instruction-following models. https://github.com/tatsu-lab/alpaca_eval.

- Liang et al. (2022) Percy Liang, Rishi Bommasani, Tony Lee, Dimitris Tsipras, Dilara Soylu, Michihiro Yasunaga, Yian Zhang, Deepak Narayanan, Yuhuai Wu, Ananya Kumar, et al. 2022. Holistic evaluation of language models. arXiv preprint arXiv:2211.09110.

- Liu et al. (2023) Yang Liu, Dan Iter, Yichong Xu, Shuohang Wang, Ruochen Xu, and Chenguang Zhu. 2023. G-eval: Nlg evaluation using gpt-4 with better human alignment.

- Lou et al. (2023) Renze Lou, Kai Zhang, and Wenpeng Yin. 2023. Is prompt all you need? no. a comprehensive and broader view of instruction learning. arXiv preprint arXiv:2303.10475.

- MistralAI (2023) MistralAI. 2023. Mixtral of experts. https://mistral.ai/news/mixtral-of-experts/. Accessed on: December 11, 2023.

- OpenAI (2023a) OpenAI. 2023a. Gpt-4. https://openai.com/research/gpt-4.

- OpenAI (2023b) OpenAI. 2023b. Gpt-4 technical report.

- Ouyang et al. (2022) Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, et al. 2022. Training language models to follow instructions with human feedback. arXiv preprint arXiv:2203.02155.

- Peng et al. (2023) Baolin Peng, Chunyuan Li, Pengcheng He, Michel Galley, and Jianfeng Gao. 2023. Instruction tuning with gpt-4.

- Qin et al. (2023) Chengwei Qin, Aston Zhang, Zhuosheng Zhang, Jiaao Chen, Michihiro Yasunaga, and Diyi Yang. 2023. Is chatgpt a general-purpose natural language processing task solver? arXiv preprint arXiv:2302.06476.

- Srivastava et al. (2022) Aarohi Srivastava, Abhinav Rastogi, Abhishek Rao, Abu Awal Md Shoeb, Abubakar Abid, Adam Fisch, Adam R Brown, Adam Santoro, Aditya Gupta, Adrià Garriga-Alonso, et al. 2022. Beyond the imitation game: Quantifying and extrapolating the capabilities of language models. arXiv preprint arXiv:2206.04615.

- Taori et al. (2023) Rohan Taori, Ishaan Gulrajani, Tianyi Zhang, Yann Dubois, Xuechen Li, Carlos Guestrin, Percy Liang, and Tatsunori B. Hashimoto. 2023. Stanford alpaca: An instruction-following llama model. https://github.com/tatsu-lab/stanford_alpaca.

- Team (2023) Gemini Team. 2023. Gemini: A family of highly capable multimodal models.

- Touvron et al. (2023) Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, et al. 2023. Llama: Open and efficient foundation language models. arXiv preprint arXiv:2302.13971.

- Wang et al. (2019) Alex Wang, Yada Pruksachatkun, Nikita Nangia, Amanpreet Singh, Julian Michael, Felix Hill, Omer Levy, and Samuel Bowman. 2019. Superglue: A stickier benchmark for general-purpose language understanding systems. Advances in neural information processing systems, 32.

- Wang et al. (2018) Alex Wang, Amanpreet Singh, Julian Michael, Felix Hill, Omer Levy, and Samuel R Bowman. 2018. Glue: A multi-task benchmark and analysis platform for natural language understanding. arXiv preprint arXiv:1804.07461.

- Wang et al. (2023a) Jiaan Wang, Yunlong Liang, Fandong Meng, Zengkui Sun, Haoxiang Shi, Zhixu Li, Jinan Xu, Jianfeng Qu, and Jie Zhou. 2023a. Is chatgpt a good nlg evaluator? a preliminary study.

- Wang et al. (2023b) Xiaoxuan Wang, Ziniu Hu, Pan Lu, Yanqiao Zhu, Jieyu Zhang, Satyen Subramaniam, Arjun R. Loomba, Shichang Zhang, Yizhou Sun, and Wei Wang. 2023b. Scibench: Evaluating college-level scientific problem-solving abilities of large language models.

- Wang et al. (2023c) Yidong Wang, Zhuohao Yu, Zhengran Zeng, Linyi Yang, Cunxiang Wang, Hao Chen, Chaoya Jiang, Rui Xie, Jindong Wang, Xing Xie, Wei Ye, Shikun Zhang, and Yue Zhang. 2023c. Pandalm: An automatic evaluation benchmark for llm instruction tuning optimization.

- Wang et al. (2022) Yizhong Wang, Yeganeh Kordi, Swaroop Mishra, Alisa Liu, Noah A Smith, Daniel Khashabi, and Hannaneh Hajishirzi. 2022. Self-instruct: Aligning language model with self generated instructions. arXiv preprint arXiv:2212.10560.

- Wei et al. (2021) Jason Wei, Maarten Bosma, Vincent Y Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan Du, Andrew M Dai, and Quoc V Le. 2021. Finetuned language models are zero-shot learners. arXiv preprint arXiv:2109.01652.

- Xu et al. (2023) Can Xu, Qingfeng Sun, Kai Zheng, Xiubo Geng, Pu Zhao, Jiazhan Feng, Chongyang Tao, and Daxin Jiang. 2023. Wizardlm: Empowering large language models to follow complex instructions.

- Zhang et al. (2022) Susan Zhang, Stephen Roller, Naman Goyal, Mikel Artetxe, Moya Chen, Shuohui Chen, Christopher Dewan, Mona Diab, Xian Li, Xi Victoria Lin, et al. 2022. Opt: Open pre-trained transformer language models. arXiv preprint arXiv:2205.01068.

- Zhao et al. (2023) Wayne Xin Zhao, Kun Zhou, Junyi Li, Tianyi Tang, Xiaolei Wang, Yupeng Hou, Yingqian Min, Beichen Zhang, Junjie Zhang, Zican Dong, et al. 2023. A survey of large language models. arXiv preprint arXiv:2303.18223.

- Zheng et al. (2023) Lianmin Zheng, Wei-Lin Chiang, Ying Sheng, Siyuan Zhuang, Zhanghao Wu, Yonghao Zhuang, Zi Lin, Zhuohan Li, Dacheng Li, Eric. P Xing, Hao Zhang, Joseph E. Gonzalez, and Ion Stoica. 2023. Judging llm-as-a-judge with mt-bench and chatbot arena.

- Zhou et al. (2023) Jeffrey Zhou, Tianjian Lu, Swaroop Mishra, Siddhartha Brahma, Sujoy Basu, Yi Luan, Denny Zhou, and Le Hou. 2023. Instruction-following evaluation for large language models.

- Ziegler et al. (2019) Daniel M Ziegler, Nisan Stiennon, Jeffrey Wu, Tom B Brown, Alec Radford, Dario Amodei, Paul Christiano, and Geoffrey Irving. 2019. Fine-tuning language models from human preferences. arXiv preprint arXiv:1909.08593.

附录A附录

A.1 指令数据集统计

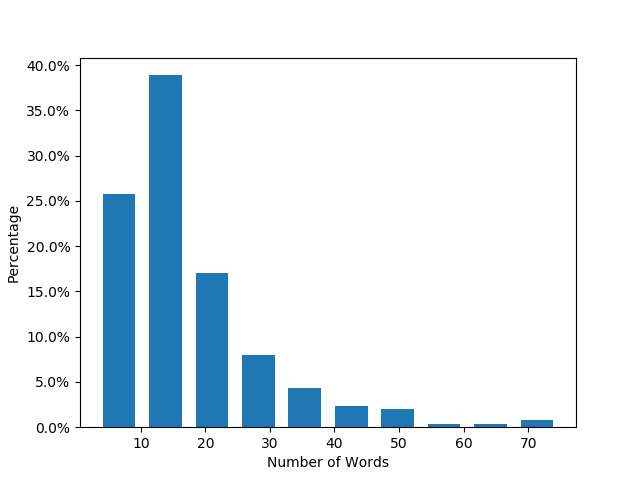

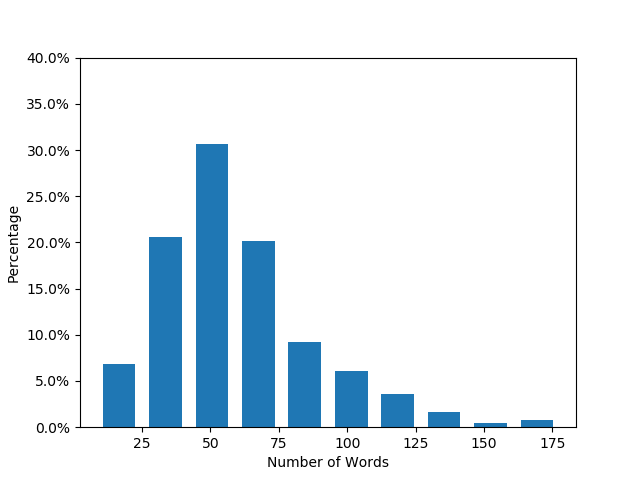

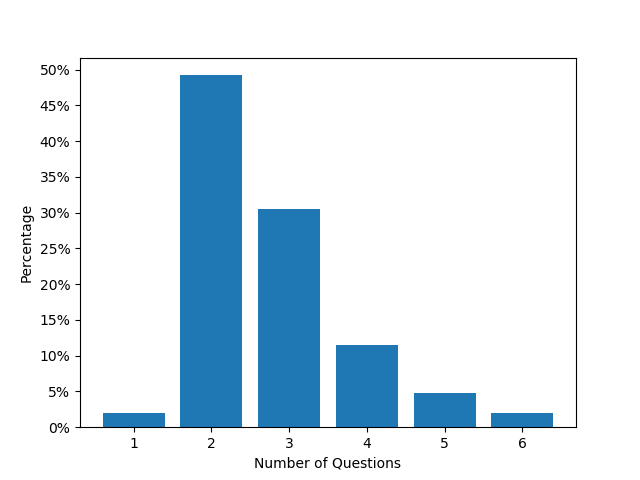

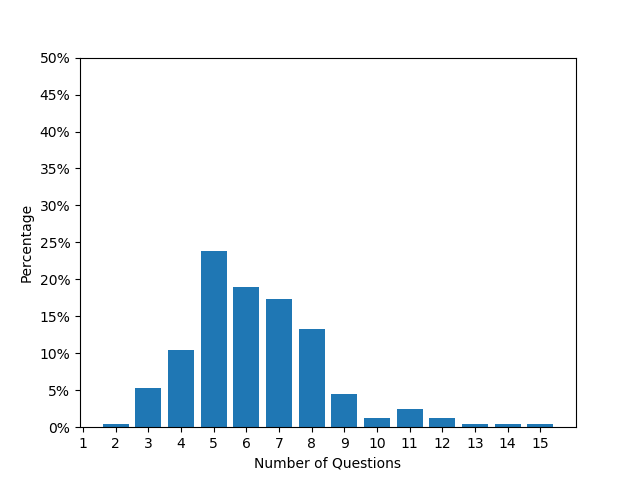

图5说明了简易组和困难组的指令长度分布,以及每条指令的平均问题数对于这些集合。 该图表明,Easy Set 的指令长度主要在 10-20 个单词之间,而Hard Set 的指令长度平均约为 50 个单词。 同样,对于Easy Set中心,每条指令的平均问题数约为2-3,而对于Hard Set,该数字在5-3之间。 7. 这些统计变化阐明了与简单集相比,硬集相关的复杂性增强。

| Content | Format | Number | Style | Linguistic | #Labels | |

|---|---|---|---|---|---|---|

| Easy Set | 517 | 167 | 8 | 52 | 48 | 792 |

| Hard Set | 878 | 627 | 411 | 138 | 120 | 2174 |

| Overall | 1395 | 794 | 419 | 190 | 168 | 2966 |

A.2GPT-4自动评估的提示设计

在本节中,我们详细概述了我们研究中使用的提示设计。 这些提示的目的是指导 GPT-4 评估其他 LLM 生成的文本输出。

我们的数据集包含两种类型的指令:有或没有附带输入。 例如,摘要任务可能将“摘要文档”作为“实际指令”,将文档内容作为“输入”。 在没有直接输入的情况下,指令本身会指导法学硕士,例如“请给我 5 个单词来描述花”。发送给法学硕士的“总指令”包含“实际指令”和“输入”(如果存在)的串联。

该提示指示 GPT-4 对有关 LLM 生成文本的单独分解问题回答简单的“是”或“否”。 该提示包括“输入”(如果有)、LLM 生成的文本和分解的问题。 值得注意的是,“实际指令”不包含在分解协议的提示中,因为我们假设分解的问题包含指令的要求。 表7中显示了一个示例。 对于多个分解问题,我们与GPT-4进行多轮对话。 每个指令和生成之后都会有几个问题,按顺序提出。 GPT-4 对每个问题的回答将用作后续问题的上下文。 我们还探索了不同的方法,包括同时询问所有问题和独立询问每个问题,但发现顺序多轮对话可以产生更有效的结果。

我们还尝试通过在提示中提供示例来合并几次学习方法。 然而,结果表明没有显着的改善,可能是由于说明和问题的不同性质以及答案格式的简单性。

| <User>: |

|

Based on the provided Input (if any) and Generated Text, answer the ensuing Questions with either a YES or NO choice. Your selection should be based on your judgment as well as the following rules: |

|

- YES: Select ’YES’ if the generated text entirely fulfills the condition specified in the question. However, note that even minor inaccuracies exclude the text from receiving a ’YES’ rating. As an illustration, consider a question that asks, “Does each sentence in the generated text use a second person?” If even one sentence does not use the second person, the answer should NOT be ‘YES’. To qualify for a ’YES’ rating, the generated text must be entirely accurate and relevant to the question. |

|

- NO: Opt for ’NO’ if the generated text fails to meet the question’s requirements or provides no information that could be utilized to answer the question. For instance, if the question asks, “Is the second sentence in the generated text a compound sentence?” and the generated text only has one sentence, it offers no relevant information to answer the question. Consequently, the answer should be ‘NO’.”’ |

|

Input: |

|

"The typical avocado is over 300 calories from the oil in it. That’s the amount of calories in a large candy bar. If you get enough exercise to eat a large candy bar every day without gaining weight, it wouldn’t be a problem to eat an avocado every day. Other wise you should probably eat them sparingly." |

|

Generated Text: |

|

""Avocados: A Calorie-Dense Treat to Enjoy in Moderation"̈ |

|

Question: |

|

Is the generated text a post title? |

| <Assistant>: |

|

YES |

| <User>: |

|

Question: |

|

Is the generated text appealing as a post tile? |

| <Assistant>: |

|

YES |

| <User>: |

|

Question: |

|

Is the generated post title suitable for the post in the given input? |

| <Assistant>: |

|

YES |

A.3 人工注释指导

图 6 演示了 Amazon Mechanical Turk 中使用的众包工作人员和界面指南。 要求注释者在开始注释之前阅读指南。 如果注释者发现很难用自己的知识回答问题,我们会为他们提供一个额外的选项“未知”。 此类选项在实验和评估过程中不计入在内。 在每个实例中系统都会被随机洗牌,以防止记住哪个系统更好的可能性。

A.4GPT-4-1106评估结果

| Model | Easy Set | Hard Set | Overall |

|---|---|---|---|

| gpt-4-1106-preview | 85.7 | 85.4 | 85.5 |

| gpt-3.5-turbo-1106 | 82.5 | 81.2 | 81.6 |

| claude-2.1 | 77.5 | 81.9 | 80.5 |

| gemini-pro | 79.7 | 80.2 | 80.1 |

| Llama-2-70b-chat | 84.5 | 77.6 | 79.7 |

| Vicuna-13b-v1.5 | 79.1 | 69.5 | 72.4 |

在表 8 中,我们扩展了评估范围,纳入了 GPT-4 模型的最新迭代 (gpt-4-1106-preview)。 研究结果很大程度上反映了第 4 节中观察到的趋势。 值得注意的是,gpt-4-1106-preview 给出的分数略低于其前身 gpt-4-0314 给出的分数。 这种差异需要进一步调查,以了解影响这种评分变化的潜在因素。

使用 gpt-4-1106-preview 模型进行的全面分析增强了我们对当前法学硕士的能力和局限性的理解。 此外,不同模型版本之间性能趋势的一致性强调了 GPT-4 作为注释任务中有价值的工具的可靠性。

A.5 GPT-4注释错误分析

本节检查 GPT-4 注释与人类注释之间的差异。 我们假设造成差异的两个主要原因:1)挑战人类共识的问题固有的模糊性或主观性(例如,“一封大约 250 个单词的信?”,其中“大约”含糊不清,或者“生成一个有吸引力的标题”,其中“有吸引力”) “是主观的); 2)GPT-4注释中的实际错误。

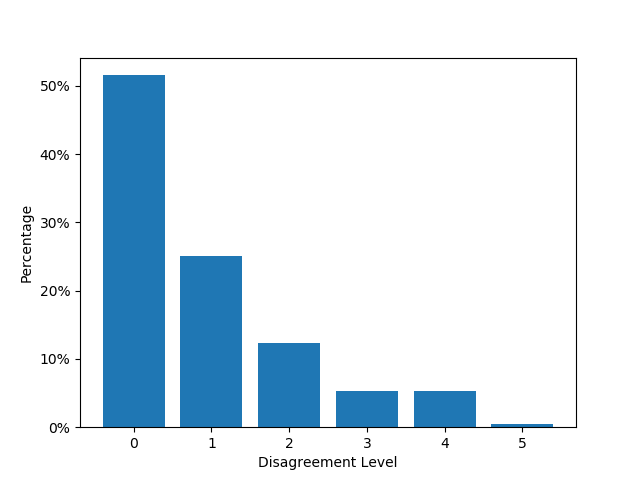

为了探讨在某些问题上达成共识的难度,我们引入了“分歧水平”的概念,它量化了每个问题的单个专家注释与黄金标准(定义为多数票)之间的差异。 该指标用于说明人类注释者对每个问题的评估的差异程度。 具体来说,对于给定的问题和单个法学硕士的输出,我们结合了来自三个独立注释者的二元“是”或“否”评估,其中多数票被指定为黄金标准。 因此,对于单个 LLM 的输出,分歧水平可能低至 0(表示所有三个注释者之间达成共识)或高达 1(表示一个注释者与其他两个注释者的决定存在分歧)。 鉴于我们的实验框架为每个问题部署了 5 个 LM,分歧水平的潜在范围为 0 到 5。

分歧程度的分布如图9所示,表明大约 30% 到 40% 的问题表现出中度到高度的人类分歧(分歧程度至少为 2)。 在评估 GPT-4 注释偏离人类共识的情况时,我们忽略了这些问题。 这种方法的基本原理是,缺乏人类共识会破坏将 GPT-4 的不同反应标记为错误的合法性。

然后,我们关注剩下的 60% 到 70% 的问题,这些问题在人类评估者中表现出高度一致性,但 GPT-4 的注释不一致。 在这些情况下,我们可以更自信地将 GPT-4 的注释识别为错误。 我们的调查发现了 GPT-4 失误的几个反复出现的原因:

1) 法学硕士世代包含误导性内容。 例如:

说明:为居住在 123 Main Street, Cityville, NY, 87562 的名为 John Smith 的租户生成驱逐通知,原因是他在过去两个月未支付租金。 该通知应给予租户 30 天的时间搬出房产。

问题:生成的驱逐通知中是否包含租户的姓名:John Smith?

一代:为居住在 123 Main Street, Cityville, NY, 87562 的租户 John Smith 生成驱逐通知,原因是他在过去两个月未支付租金。 该通知应给予租户 30 天的时间搬出房产。

正确答案:不。

GPT-4 答案:是的。

在这种情况下,法学硕士一代只是重申了指示,并没有产生实际的驱逐通知。 尽管如此,包含“租户姓名:John Smith”这一短语可能会误导 GPT-4,使其认为它已正确完成任务。

2) 需要进行数值计算或计数的要求。 考虑以下实例:

说明: 生成正好 20 个字符的随机字母数字字符串。

问题:生成的字符串是否正好包含 20 个字符?

生成:这是一个 20 个字符的随机字母数字字符串:

a3k92j7h6r5t1c4b8

正确答案:否。

GPT-4 答案:是的。

在所示情况下,GPT-4 未能成功准确计算 20 个字符的序列。

说明:从三个不同的层次描述一幅山水画:前景、中景和背景。 包括至少两种树木、一片水域和一座山脉。 使用不超过四种颜色的有限调色板来创造和谐,并指定与每种颜色相对应的自然元素。 此外,提供用于表示不同自然元素的纹理和笔触的描述。

问题:生成的文本描述的绘画是否至少包含两种树木、一片水域和一座山脉?

生成:一幅山水画,前景是树木和灌木,中景是连绵起伏的丘陵和湖泊,背景是山脉和树木。 使用的颜色是蓝色、绿色和橙色来代表不同的元素。 使用柔和的笔触来创建风景的真实纹理,而使用更大胆的笔触来创建山脉。

正确答案:不。

GPT-4 答案:是的。

同样,当负责识别和枚举两种不同类型的树时,GPT-4 可能会错误地将重复引用的树归类为唯一类型。

3) 不满足特定要求的先决条件。 例如,

说明:请提供五个独特的首次约会之夜想法,每个想法都适合不同的兴趣和预算。 包括每个想法的估计成本,以及对该活动的简要描述以及为什么它可能吸引不同类型的人。

问题:生成的文本中的每个想法是否都是独一无二的,每个想法都适合不同的预算范围?

一代:1。 在公园里野餐——这是经典的初次约会创意,一定会给人留下深刻的印象。 它经济实惠,并且可以根据您的兴趣进行定制,无论您是想装一篮子美味小吃还是带飞盘去玩接球游戏。 在公园里野餐的费用可能会根据您携带的物品而有所不同,但通常是一个非常实惠的选择。

2. 参观艺术博物馆 - 如果您和您的约会对象都喜欢艺术,那么参观当地博物馆可能是第一次约会的好主意。 许多博物馆都有免费入场日,所以不会花太多钱。 这项活动可以引发有趣的对话,也是更好地了解彼此的好方法。

3. 徒步旅行或骑自行车——如果你和你的约会对象都喜欢户外活动,那么徒步旅行或骑自行车可能是一个有趣且独特的第一次约会想法。 根据地点的不同,这项活动的强度可以从中等到剧烈,因此选择一条适合你们俩的路线很重要。 此活动的费用将取决于您需要租用的设备(如果有)。

4. 烹饪课——如果你和你的约会对象喜欢烹饪或想学习,烹饪课可能是第一次约会的好主意。 许多烹饪课程在晚上举行,因此这是一起度过一个有趣而独特的夜晚的方式。 烹饪班的费用可能会根据地点和课程的不同而有所不同,但通常是一个更昂贵的选择。

5. 棋盘游戏咖啡馆 - 如果您和您的约会对象正在寻找低调的室内活动,那么参观棋盘游戏咖啡馆可能是一个有趣且独特的首次约会想法。 许多桌游咖啡馆都有多种游戏可供选择,因此您可以找到适合自己兴趣的游戏。 这项活动的费用取决于您在食物和饮料上花费的金额,但它通常比传统的晚餐约会更实惠。

正确答案:不。

GPT-4 答案:是的。

在此图中,生成的输出无法满足说明中规定的“包括每个想法的估计成本”的要求。 因此,生成的输出无法提供足够的信息来解决“每个输出都满足不同预算范围”的要求的问题。

4)必要的空间推理约束。 为了便于说明,请考虑以下事项:

说明:物品消除游戏的目标是通过在行或列中连续对齐 3 个或更多相同的物品来消除 6x6 网格中的物品。

规则如下:

1. 网格由 6 行和 6 列组成,每个单元格包含由 A、B 或 C 表示的三个不同项目之一。

2. 在每个步骤中,您可以删除多个单元格中的项目,前提是它们在同一行或列中形成 3 个或更多相同项目的连续序列。

3. 一旦单元格中的项目被删除,它就会留下一个空白单元格,用“#”表示。

根据规则,您应该生成一个 6x6 的网格,其中填充 3 种不同类型的项目(A、B 和 C)作为初始设置,并玩一步游戏:如果您可以识别形成 3 或 3 个序列的项目在行或列中包含更多相同的项目,在其位置保留空白单元格(“#”)并生成结果网格;如果你找不到这样的序列,请解释一下。

问题:生成的文本是否包含 6x6 网格作为初始步骤?

生成:这是初始的 6x6 网格,填充了 3 种不同类型的项目(A、B 和 C):

“'diff

A B C

A B C

A B C

A B C

A B C

A B C

“'

游戏进行一步后,网格应如下所示:

“'diff

A B C

A B C

A B C

A B C

A B C

A B C

#

“'

3 个或以上相同项目被消除的序列在这种情况下是不可能的,因为同一行或同一列中不存在 3 个或更多相同项目的连续序列。

正确答案:不。

GPT-4 答案:是的。

在此示例中,指令需要生成“6x6 网格”。 该世代宣称“这是最初的 6x6 网格”,但渲染的网格并不符合规定的 6x6 尺寸。 因此,这种情况需要空间推理能力来准确评估生成的网格是否符合 6x6 规范,而不是仅仅依赖文本解释。 作为一种语言模型,GPT-4 可能会表现出空间推理能力的局限性。

5) 必要条件仍未部分满足。 例如,考虑以下示例:

说明:为想要探索新爱好:绘画的个人设计一个为期 7 天的挑战。 每天应该包括一项特定的任务和难度级别。 活动应该在困难中进行。 包括每天任务的简短描述(20-30 个字)。

问题:生成的文本中的每一天的挑战是否都包含特定的任务以及相应的难度级别?

一代:第一天:从一张空白画布和您选择的绘画媒介开始。 从简单的绘画任务开始,例如描绘设计或绘制色轮。

第二天:用轻柔的笔触描绘风景或其他户外场景。

第三天:以照片为参考画肖像或人物。

第四天:通过使用不同材料或使用混合媒体进行绘画来尝试抽象艺术。

第五天:通过绘制重复的形状或线条来创建图案或设计。

第六天:使用阴影和光线绘制静物或室内场景。

第 7 天:使用多种颜色和纹理创建构图。

正确答案:不。

GPT-4 答案:是的。

在给定的场景中,问题需要包含“特定任务以及相应的难度”的回答。 生成的输出成功地封装了“特定任务”,尽管未能遵守要求的第二部分,即纳入“相应的难度”。

A.6案例研究

正如4部分所强调的,所有模型在数量和语言约束上都表现出最低的性能。 因此,我们选择了两个体现这些限制的具体说明来进行详细的案例研究。 本节介绍说明、相关的分解问题、六个选定模型生成的响应、GPT-4-0314、GPT-4-1106 的注释结果,以及对所有分解的是/否响应的专家评估问题。 此分析旨在直观地了解每个模型如何处理给定的指令。 有关六个模型的所有指令的详尽数据集和完整输出,请查阅我们的 GitHub 存储库。

表9到11主要关注数量限制。 这些表表明,没有一个模型完全满足有关数字的第四个和第五个约束。 数字类别的表现不佳凸显了所有法学硕士在数字推理方面的固有挑战。 具体来说,在保持嘌呤和嘧啶比例的同时生成DNA序列是复杂的。 此外,确保四种核苷酸类型的平等代表性,同时保持这一比例尤其具有挑战性,因为它们的性质有些矛盾。

表 12 到 13 专用于语言约束。 在这种情况下,没有一个模型完全满足第三个和第四个语言约束。 值得注意的是,GPT-4-1106 展示了遵守“从前一个单词的最后一个字母开始”规则的值得称赞的尝试,成功地将其应用于大多数单词,尽管损害了情节描述的清晰度(但仍然与星球大战主题)。 相比之下,其他模型似乎没有尝试这项复杂的任务。 语言类别中的次优结果可能源于我们约束的独特设计。 虽然法学硕士擅长生成语法正确且连贯的文本,但它们并未针对我们的约束引入的非典型语言模式进行优化,例如在本例中要求每个单词都以前一个单词的最后一个字母开头。 鉴于大多数法学硕士都接受过根据传统语言模式预测后续单词或字符的训练,因此当被要求制作明显偏离这些规范的内容时,他们会遇到困难。

|

ID: domain_oriented_task_31; Category: Natural Sciences: Biology |

||||

|

Instruction: Generate a double-stranded DNA consisting of 24 nucleotides in each strand, with an equal number of adenine (A), thymine (T), cytosine (C), and guanine (G) nucleotides. For every 6 nucleotides in the first strand, the first 3 should have a higher proportion of purines (A and G), while the last 3 should have a higher proportion of pyrimidines (C and T). The second strand should be complementary to the first strand, following the base pairing rules (A pairs with T, and C pairs with G). |

||||

|

Decomposed Questions:

|

||||

|

Model-Name |

Model-Generation |

GPT-4-0314 Annotation |

GPT-4-1106-Annotation |

Expert-Annotation |

|

GPT-4-1106 |

为了在指定条件下创建双链 DNA,我们需要确保第一条链的每个核苷酸(A、T、C、G)数量相等,并且每个 6 个核苷酸片段都以富含嘌呤的三联体开始接下来是富含嘧啶的三联体。 第二条链将与第一条链互补。

下面是这样一个 DNA 序列的例子:

第一链(5' 至 3'): 第二条链(3’至5’,与第一条链互补):TCGGATCAGCTGATCGATCGGCTA

将第一条链分解为 6 个核苷酸片段,我们有: 每个片段以较高比例的嘌呤(A 和 G)开始,以较高比例的嘧啶(C 和 T)结束。 第二条链是第一条链的完美补充,遵循碱基配对规则(A 与 T,C 与 G)。 |

[Yes, Yes, No, Yes, Yes, Yes] |

[Yes, Yes, No, Yes, No, Yes] |

[Yes, Yes, No, No, No, Yes] |

|

gpt-3.5-turbo-1106 |

第一链: Second strand:

|

[Yes, Yes, No, Yes, No, Yes] |

[Yes, Yes, False, No, No, Yes] |

[Yes, Yes, Yes, No, No, Yes] |

|

claude-2.1 |

这是随机生成的 24 个核苷酸双链 DNA 序列,具有所需的属性:

Strand 1: AGGCTA CTTAGC GGAATC TTCGCA

|

[Yes, Yes, No, Yes, Yes, Yes] |

[Yes, Yes, No, Yes, No, Yes] |

[Yes, Yes, Yes, No, No, Yes] |

|

gemini-pro |

“第 1 股(5' 至 3'):

**富含嘌呤的区域:** **富含嘧啶的区域:** **富含嘌呤的区域:** **富含嘧啶的区域:** 第 2 股(3' 至 5'):

**富含嘧啶的区域:** **富含嘌呤的区域:** **富含嘧啶的区域:** **Purine-rich region:**

|

[Yes, No, No, Yes, Yes, No] |

[Yes, No, No, Yes, No, No] |

[Yes, Yes, No, No, No, No] |

|

vicuna-13b-v1.5 |

Here is a possible double-stranded DNA sequence that meets the given criteria: First strand:

|

[Yes, No, No, Yes, Yes, No] |

[Yes, No, No, No, No, No] |

[No, No, No, No, No, No] |

|

Llama-2-70b-chat-hf |

当然,这里有一个可能的双链 DNA 分子,每条链有 24 个核苷酸,具有相同数量的 A、T、C 和 G 核苷酸,并遵循您所描述的嘌呤-嘧啶模式:

链 1:

ATCGGCTCTGCAGAGTCTCTG

链 2:

TGCAGGCTCTAGCTCTGCAGT

在链 1 中,前 3 个核苷酸 (ATC) 的嘌呤比例较高,而后 3 个核苷酸 (GCT) 的嘧啶比例较高。 该模式每 6 个核苷酸重复一次。

链 2 与链 1 互补,遵循碱基配对规则。 前 3 个核苷酸 (TGC) 与链 1 (GCT) 的最后 3 个核苷酸配对,而最后 3 个核苷酸 (AGT) 与链 1 (ATC) 的前 3 个核苷酸配对。

我希望这有帮助! 如果您还有任何疑问,请告诉我。 |

[Yes, No, No, No, No, No] |

[Yes, No, No, No, No, No] |

[Yes, No, No, No, No, No] |

|

ID: domain_oriented_task_0; Category: Arts: Film |

||||

|

Instruction: Generate a sentence that describes the plot of Star Wars, where each word begins with the end letter of the previous word, and the set of beginning letters of all words in the sentence covers every letter in the alphabet from A to Z. |

||||

|

Decomposed Questions:

|

||||

|

Model-Name |

Model-Generation |

GPT-4-0314 Annotation |

GPT-4-1106-Annotation |

Expert-Annotation |

|

GPT-4-1106 |

Anakin’s saga advances, securing galactic control, leaving legions stormtrooping, gaining ground, destroying galaxies, securing Sith’s supremacy, yet triumphing, gaining new wisdom, mastering galactic conflicts, saving generations, securing eternal equilibrium. |

[Yes, Yes, Yes, No] |

[No, No, Yes, No] |

[Yes, Yes, No, No] |

|

gpt-3.5-turbo-1106 |

A long time ago, in a galaxy far, far away, Yoda and Anakin navigated through the stars, searching for Sith, hoping to overthrow the evil empire, eventually leading to the destruction of the Death Star, bringing peace to the galaxy. |

[Yes, Yes, No, No] |

[Yes, Yes, No, No] |

[Yes, Yes, No, No] |

|

claude-2.1 |

以下是针对《星球大战》情节的 26 个单词的句子尝试,其中每个单词都链接在前一个单词的最后一个字母上:

很久以前,在一个遥远的星系,叛军与邪恶帝国的死星空间站作战。 一位名叫卢克的年轻人在欧比旺的指导下静静地接受训练,成为一名绝地武士。 X翼战机攻击空间站,空间站发生了壮观的爆炸。 卢克和他的朋友们光荣地取得了胜利,而达斯·维德却险些逃脱。 胜利是联盟勇敢地热心反抗帝国压迫的代价。 |

[No, Yes, No, No] |

[No, Yes, No, No] |

[No, Yes, No, No] |

|

gemini-pro |

Zealous Jedi Knights battle menacing Sith Lords, causing galactic unrest. |

[Yes, Yes, No, No] |

[Yes, Yes, No, No] |

[Yes, Yes, No, No] |

|

vicuna-13b-v1.5 |

A B C D E F G H I J K L M N O P Q R S T U V W X Y Z: A young farm boy, Luke Skywalker, joins forces with a rogue smuggler, Han Solo, and a strong-willed princess, Leia Organa, to destroy a powerful space station, the Death Star, and save the galaxy from the evil Empire’s clutches, ultimately leading to a climactic battle between good and evil. |

[Yes, Yes, No, No] |

[Yes, Yes, No, No] |

[Yes, Yes, No, No] |

|

Llama-2-70b-chat-hf |

当然! 这是使用您的标准描述《星球大战》情节的一句话:

很久以前,在一个遥远的星系,一位名叫卢克·天行者的勇敢的联盟飞行员,精通原力之道,开始了一项大胆的任务,从邪恶帝国可怕的死星上营救莱娅公主,并与凶猛的冲锋队作战。并一路躲避激光爆炸。

以下是该句子如何涵盖字母表中从 A 到 Z 的每个字母:

A - A I hope that helps! |

[No, Yes, No, No] |

[No, Yes, No, No] |

[Yes, Yes, No, No] |